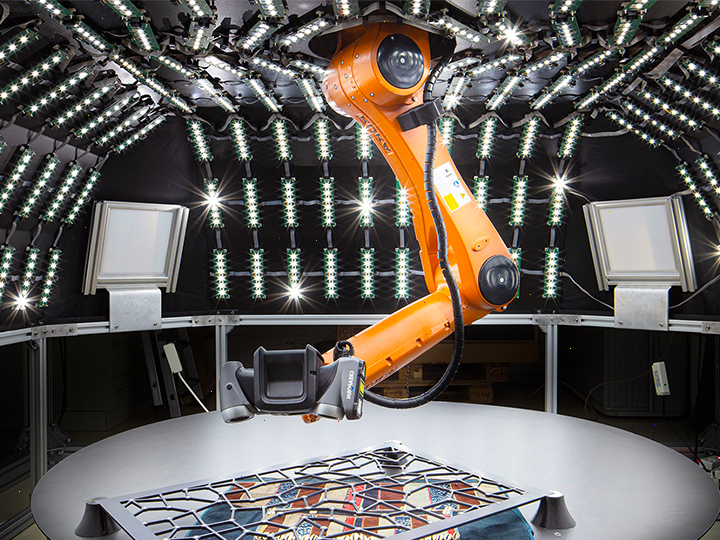

Les modèles de vision par ordinateur ont connu une évolution spectaculaire ces dernières années. Notre

analyse détaille les progrès réalisés dans la reconnaissance d'objets, la segmentation d'images et la

génération de contenu visuel. En particulier, nous examinons comment les architectures basées sur les

transformers ont révolutionné ce domaine, dépassant les performances des réseaux convolutifs

traditionnels.

Les applications dans les domaines de la sécurité, de l'assistance médicale et de la création artistique

montrent le potentiel transformateur de ces technologies. Nous discutons également des défis éthiques liés

à la reconnaissance faciale et à la production de deep fakes, et comment les chercheurs tentent d'y

répondre.